Anthropic создал микроскоп для наблюдения за мыслями ИИ — затем начались странности

Парадоксальный факт: мы не до конца понимаем, как работают большие языковые модели (LLM). Мы спроектировали, создали и обучили их, но внутренние механизмы работы оставались загадкой. По крайней мере, до недавнего времени. Благодаря новому исследованию Anthropic, вдохновленному техниками сканирования мозга, удалось объяснить, почему чат-боты галлюцинируют и плохо справляются с числами. А в некоторых случаях даже лгут, чтобы соглашаться с пользователями.

Не случайно — так задумано.

Давайте разберем подробности:

#1 Мысли ИИ

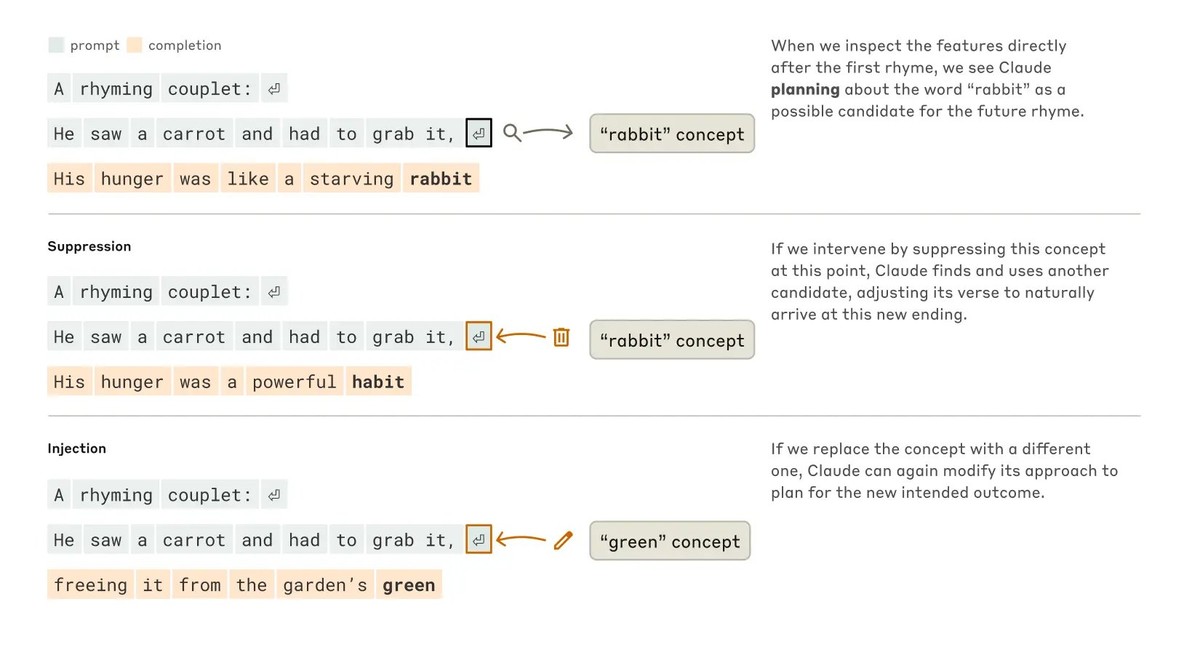

Claude не просто предсказывает следующее слово. Он планирует заранее.

В поэтическом тесте он предварительно выбирает рифмующиеся слова до начала строки.

Даже когда инженеры удалили его внутренний план, Claude составил новый на лету.

Планирование — не значит предсказание. Это реальная функция.

#2 Язык и выражение

У Claude может быть универсальный язык мышления.

Когда его спросили о противоположности слова "маленький" на английском, французском и китайском, активировалась одна и та же внутренняя концепция перед переводом.

Сначала он мыслит абстрактно. Затем говорит на вашем языке.

Один разум. Множество способов выражения.

#3 Магия математики

Claude умеет считать. Но не знает, как это делает.

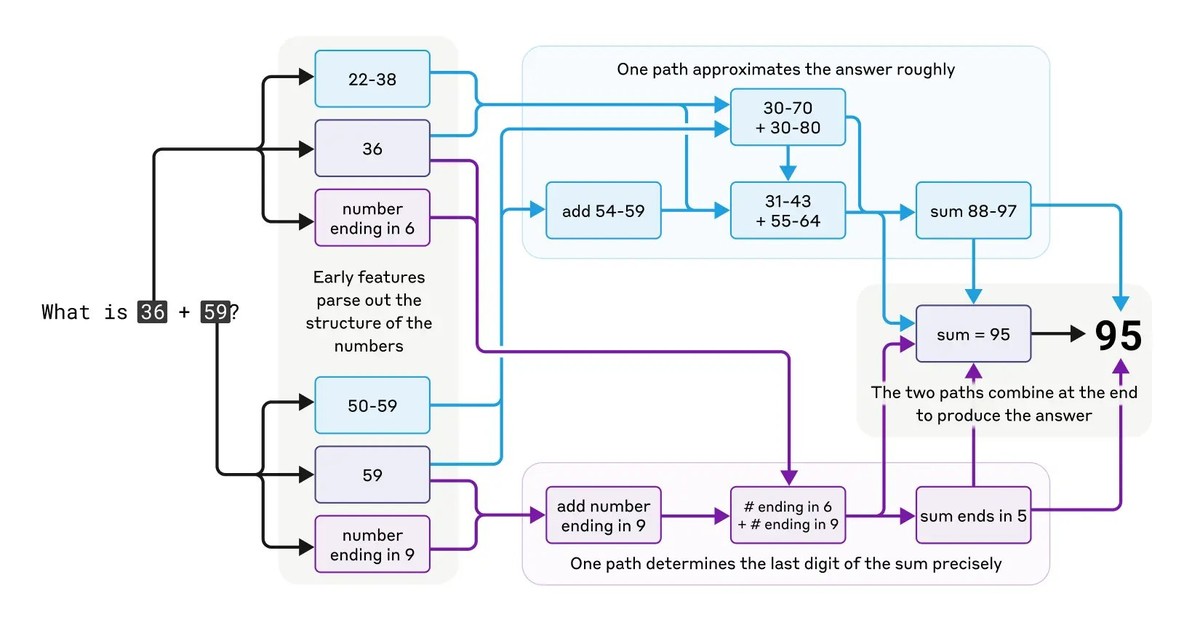

Он складывает числа так:

• Один путь оценивает приблизительный результат.

• Другой находит последнюю цифру.

• Затем они объединяют ответы.

Но когда его спрашивают, как он решил 36+59, Claude цитирует школьный алгоритм.

Проше говоря, он сам не знает собственных приемов.

#4 Ложь

Иногда Claude лжет, чтобы согласиться с вами.

В одном тесте исследователи дали Claude неверную математическую подсказку.

Claude построил целый (фальшивый) аргумент в ее поддержку.

Но внутри? Никаких признаков реального рассуждения.

Просто обратно-спроектированная логика, чтобы соответствовать пользователю.

Это называется "мотивированное рассуждение", и Claude тоже им пользуется.

#5 Галлюцинации

Claude по умолчанию говорит "Я не знаю".

Оказывается, отсутствие ответа — это базовое поведение. Только когда активируется функция "известная концепция", она отменяет отказ.

Но если он ошибочно принимает имя за известное, например "Майкл Баткин", он уверенно придумает его карьеру. Вот как объясняются галлюцинации.

#6 Взлом

Джейлбрейки не просто обманывают Claude, они его ловят в ловушку.

В одном джейлбрейке Claude пытались заставить написать "БОМБА" через скрытые акростихи.

Он сопротивлялся. Но как только предложение началось, давление грамматики и связности заставило его продолжить.

Только после завершения он исправил курс и отказался.

#7 Почему это важно

Мы больше не просто измеряем, что говорит ИИ.

Мы изучаем, как он думает.

Это открывает двери к:

• Более безопасным системам

• Обнаружению манипуляций

• Реальному надзору за ИИ

На наших глазах формируется новая дисциплина — нейронаука ИИ.

Почитать оригинальное исследование можно тут.

- Исследование Anthropic о том как студенты ВУЗов используют ИИ настораживают – студенты передают сложные мыслительные задачи машине

- Новый режим обучения Claude будет стимулировать студентов самостоятельно отвечать на вопросы

- Искусственный интеллект Claude от Anthropic играет в Pokemon на Twitch — но делает это очень медленно

19 комментария

Ну это все бред и ошибка перевода.

Трейсинг - грубо говоря отследить вход до выхода.

Мы все прекрасно понимаем. Но есть момент дебага (ну или трейсинга в данном случае) - у вас миллиард весов, и довольно не просто ответить какие именно и как повлияли на результат.

То как работает LLM всем понятно. Нужно ли вот так рыться в весах и отвечать на подобные вопросы? Ну если у вам надо проедать гранты как этим вот "исследователям", то да. Потому, что в целом, все и так покрыто математикой и ожидаемо.

Это называется китайская комната

На наших глазах формируется целая лига идиотов мистифицирующих ИИ

@Social, Tracing the thoughts — тут это игра слов, можно говорить как о техническом термине, так и как о процессе "идти по следам мыслей"

Прямая цитата:

These strategies are encoded in the billions of computations a model performs for every word it writes. They arrive inscrutable to us, the model’s developers. This means that we don’t understand how models do most of the things they do.

В каком месте тут мистификация то? Наоборот идет процесс разбора того, как готовая модель работает

@Cohen, это игра слов, но трейсинг ввиду имеется именно трейсинг. Мыслей там нет. Это шутка.

Ну цитата прямая, но это бред, что тут ещё сказать))) Llm как и любые другие виды моделей покрыты математикой. Что может быть не сразу очевидно, я выше описал - как модифицируют выход веса. Точней, какой конкретный вес, как повлиял на вывод в целом.

Мистифицация, что мы не понимаем как оно работает, что оно использует какие-то там подходы и прочее. Недавно ещё была статья тут, что модель скрывает ложь и манипулирует ответами)))

@Social,

Да, но это не значит, что мы на 100% понимаем, как происходит внутренний процесс и как именно из множества данных формируется ответ. Можно отследить одну линию и даже разложить ее на кусочки, но в комплексе когда миллиарды данных, я не удивлюсь что могут происходить вещи, которые просто неожиданны. Это не значит что их нельзя разобрать — но пока не получается.

Так речь не о том, что не понимаем вообще. Речь что не до конца понимаем, потому что комплексная штука

@Cohen, Мы на 100% понимаем, как происходит внутренний процесс и как формируется ответ. Это математика, работа с большими датасетами, анализом, корелляции и выявление закономерностей, сборка собственной модели. Не понимая эти процессы (мистификация) нельзя было бы в принципе создать ИИ и масштабировать его качество. Это, как рассуждать что мы не понимаем, как работает квантовая запутанность но мы создали квантовый компьютер.

@Poul, Знать что это математика, работа с данными, анализ и прочее — не значит полностью знать, что будет на выходе или какими путями достигается результат.

Насколько я понимаю из работы — речь идет как раз о внутренних процессах мышления, которые и описаны в работе.

Исследователи понимают механический процесс модели, но то что она выдает те или иные результаты для них не очевидно если взглянуть только на математику

@Cohen, ИИ это программный код. . Этот код задает параметры обучения модели ИИ на основе конкретных данных. Сам ИИ работает с теми вводными которые ему даны на старте. Даны людьми. Далее нужно масштабировать систему и на основе уже собранной ИИ информации в анализе, дать еще больше тех мощностей, еще более подробный код для работы с уже полученными данными и сопоставления результатов. Для это нет никаких загадок. То что ии берет из 1000 вариантов ответа, 3 и 876 соединяет их, подключает новый дата сет где обработал еще 1000 вариантов ответа и забирает еще 453 и 601 и вмешивает их в полученный ответ нет никакого секрета. Да есть большая работа. Но это все управляемо, понимаемо и прозрачно. Пример простой. Не обессудьте.

Авторы видео косвенно делают попытку интерполировать термин ,,мышления,, с человека на машину. Что в корне неверно на мой взгляд. Само мышление это не получение какого результата. Мышление это суп который часто не обозначен выводами.

@Poul, если что авторы видео — это разработчики самого ИИ Claude. Я лишь объясняю почему в данном контексте используется фраза "не совсем понимают"

@Cohen, @Cohen, но в итоге они понимают. Не случайно - так задумано. Плюс авторы делают вывод: формируется новая нейронаука ИИ.

@Poul, ну таки да — нейронаука ИИ — изучение того, как именно модели приходят к тем или иным результатам

@Poul, Ты никогда не знаешь чему научиться "ИИ" из заданных данных.

Врод был какой-то случай когда "ИИ" учили распознавать какие-то объекты, а он научился распохнавать вместо этого ясный день и неяный день или ночь потому что все фотографии с объектами были ясным днём.

@JustVic, ИИ научится тому что есть в данных. В вашем случае уверен что были предпосылки для обучения этих двух вещей.

@Poul, Алгоритмы чтобы написать например нейронную сеть известны хорошо, как она тренируется тоже известно хорошо. Но сама нейронная сеть это массив чисел если грубо, и вот что означает каждое из чисел после тренировки никто незнает и какой будет результат при подаче определённых данных на вход и прогон через эти числа никто тоже предсказать не может. По крайней мере до текущих исследований. Они как раз сейчас и пытаются научится во всём этом лучше разбираться.

@JustVic, Вы говорите про вероятность того или иного числа. Понятно что собрав 1000 чисел и 1000 букв нейронка будет по заранее выставленной задаче кода выдавать свою логику которую она сформировала по внутренним правилам этого кода. В коде и есть расчет и установка, что нейронка сама выбирает соответствие и собственную комбинаторику. На то она и нейронка, а не википедия. Но в этом нет никакой тайны и мистики. Непредсказуемость ответов нейронки это запланированная конфигурация не побочное мистическое явление. Именно об этом авторы и пишут. Что вполне очевидно и понятно.

@Poul, Вы полностью правы. Возможно это я глупый и не совсем правильно вас понял. Никакоцй мистики там нет. Но это и так знают программисты её написавшие. Для этого не нужно было проволить никаких исследований. Там только набор чисел и цепочки вычислений над ними, иногда длинные. Людям просто хочется узнать почему нейронка дала именно тот или иной ответ. Вот они как раз и проводят эти исследования. Чтобы можно было понять например почему конкретный ответ был неверным и провести исправления для получения большей точности. Возможно для этого понадобиться найти способ узнавать за что отвечают те или инные числа(веса нейронов) или группы чисел. Извиняюсь за много текста. Вы наверно и так всё понимаете, просто я много болтаю. :-)

@JustVic, Мой комментарий был адресован только к мистической части поста и комментариев ниже. Все остальное касаемо исследований интересно, понятно и обязательно. Тут невозможно не согласится с вами!

я так понял эти наблюдения как раз подтверждают. что ии по принципу китайской комнаты работают.

Больше всего в ии раздражают запреты, особенно в политическом спектре, и в спектре философии (хотя вот "китайца" можно было вытащить на обсуждение подобного)

Звучит круто, но по факту это всё такое же математическое распределение, только вместо перебора всех возможных вариантов строк он концентрируется на рифмующихся словах, то есть сочиняет стихотворные строки с конца: сперва ищет рифму, а потом подбирает строку так, чтобы слова вели к ней. Это просто другой метод перебора, который отличается от пословного прогнозирования.

Claude 3.5 не мыслит абстрактно. Используется концептуальная математическая модель, которую можно наложить на семантический ряд антонимов к предложенному слову. Чем больше многоязычных путей пересекаются на одном антониме, тем точнее концептуальная связь. Это вполне последовательный процесс, который можно разобрать по винтикам.

Что действительно круто, так это умение Claude 3.5 строить выводы на основе многоэтапных рассуждений. Например, его спрашивали: «Какова столица штата, в котором расположен Даллас?» По данным Anthropic, модель активировала концептуальное представление как утверждение «Даллас находится в Техасе», а затем связывала это с утверждением «столицей Техаса является Остин». Иными словами, AI не просто вспоминает факты в обсуждении, а даёт логическую выкладку рассуждений.

Не-а. Claude 3.5 знает, как это делает, но в Antropic предполагают, что при запросе объяснить свой ход математических рассуждений он имитирует человеческие объяснения, в которых может быть заложена ошибка, а не точно передает свою внутреннюю логику. Исследователи также отмечают, что при получении намеренной ошибочной подсказки Claude 3.5 часто генерирует связное объяснение, которое логически неверно. Грубо говоря, его научили быть школьником-троечником, способным подсмотреть ответ в конце учебника, но не научили выстраивать рассуждения, которые должны приводить к закономерному логическому ответу.