Яндекс выпустил библиотеку YaFSDP для ускорения обучения языковых моделей

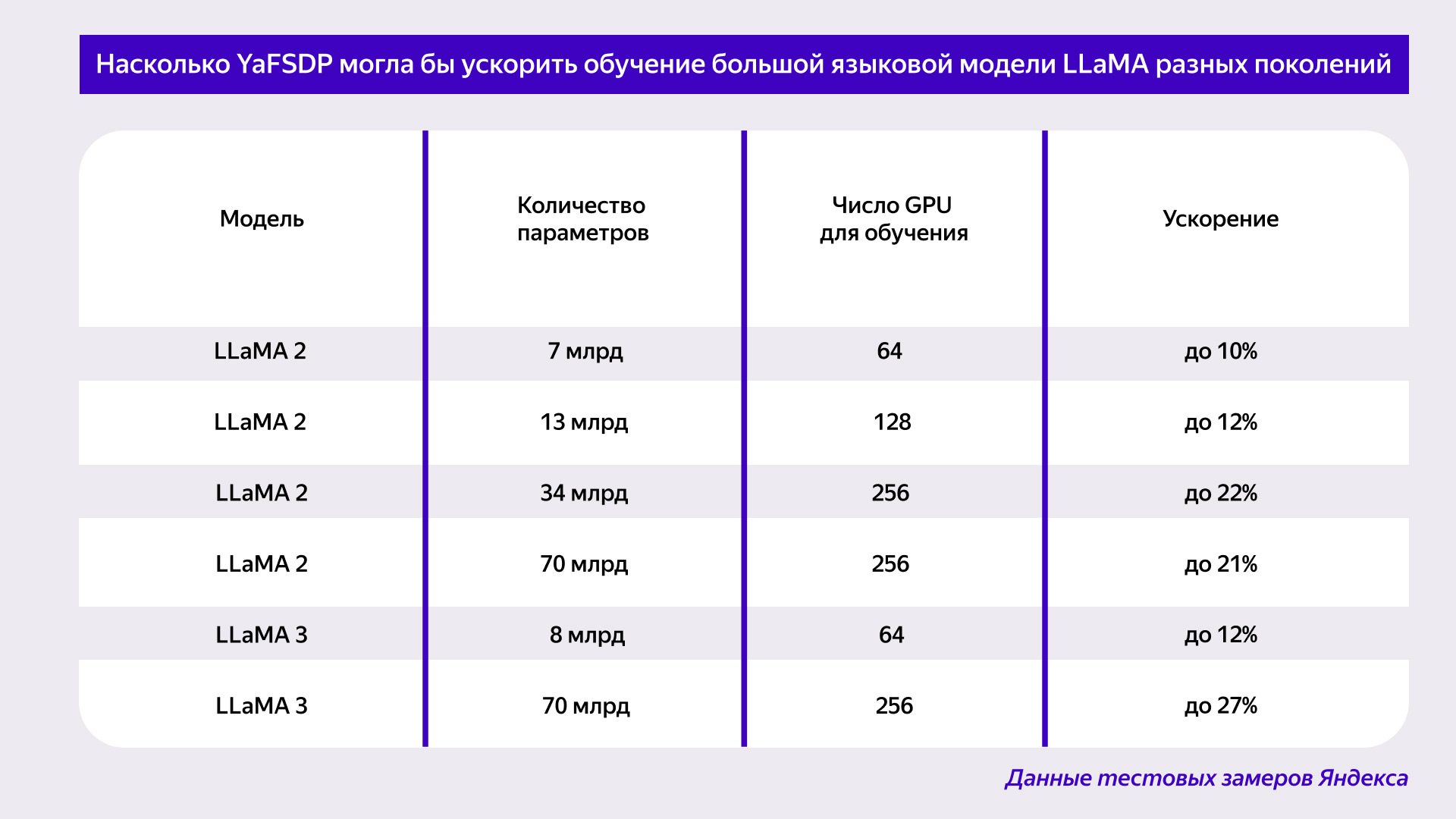

Яндекс разработал и представил доступ к исходному коду библиотеку YaFSDP, которая ускоряет обучение больших языковых моделей до 25%. Библиотека оптимизирует использование ресурсов графических процессоров (GPU), снижая их расход на 20%. Это позволит разработчикам и исследователям по всему миру эффективнее обучать нейросети.

YaFSDP решает проблему недостаточной загрузки каналов коммуникации между GPU, оптимизируя их использование на всех этапах обучения, включая предварительное, с учителем (supervised fine-tuning) и выравнивание модели (alignment). Это делает обучение более экономичным и быстрым, что особенно важно для стартапов и научных проектов.

Яндекс уже протестировал YaFSDP на сторонних нейросетях, например, на модели LLaMA 2, где время обучения сократилось с 66 до 53 дней при использовании 1024 GPU. Исходный код библиотеки доступен на GitHub, где можно ознакомиться с подробностями её работы и результатами тестирования.