Мощнее RTX 3000, пока не включен DLSS — анализ RX 6000 от Digital Foundry

Специалисты Digital Foundry провели полный анализ новых видеокарт AMD в сравнении с серией RTX 3000 от NVIDIA. Со стороны "красных" были RX 6800 и 6800 XT, который выступили против прямых конкурентов в лице RTX 3070 и 3080.

- Новая система охлаждения определенно вышла лучше предыдущей — металлический корпус отлично рассеивает тепло, а три кулера работают эффективнее и тише турбины

- Все видеокарты AMD получили по 16 ГБ видеопамяти типа GDDR6. У RTX 3070 памяти вдвое меньше, а у RTX 3080 — 10 ГБ, но GDDR6X. В реальных задачах между картами практически нет разницы, только в DOOM Eternal в 4K модели RTX 3070 явно не хватает дополнительной памяти

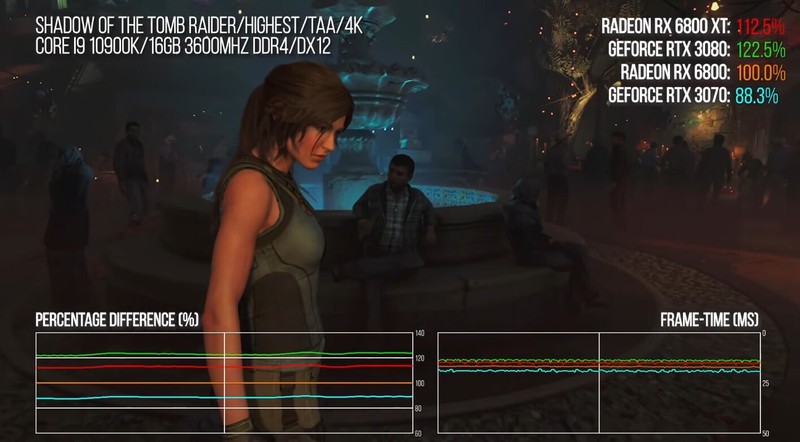

- В игровых тестах RX 6800 легко обходит RTX 3070 на 5-10%, но и стоит вариант от AMD дороже на $80. Однако это без учета DLSS и трассировки лучей

- RX 6800 XT сравнима с RTX 3080 — за счет высоких частот и более эффективной системы обращения к памяти видеокарта от AMD в некоторых моментах опережает конкурента. Однако в определенных играх (DOOM Eterrnal и Tomb Raider) Radeon отстает от GeForce почти на 10%

- При включенном DLSS разница между видеокартами достигает 50%

- В кристалле RDNA2 не предусмотрены ядра для машинного обучения, однако в будущем у RX 6000 и Xbox Series может появиться "умный" суперсемплинг от Microsoft

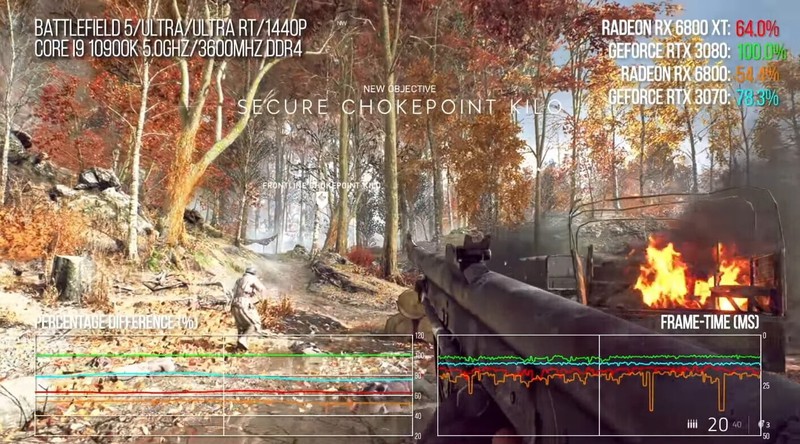

- В играх с трассировкой лучей Radeon отстает от решений NVIDIA, так как технология "съедает" больше ресурсов у видеокарт AMD

- Специалисты считают, что в будущем ситуация может измениться в лучшую сторону для AMD. Трассировка лучей станет универсальным стандартом для ААА-игр, так как сейчас даже Xbox Series S имеет поддержку этой технологии

Продажи AMD Radeon 6800 и 6800 ХТ стартовали в России 19 ноября по рекомендованной розничной цене в 53 590 рублей и 59 990 рублей соответственно. Однако, как и в случае с NVIDIA, найти видеокарты в свободной продаже достаточно сложно.

AMD работает с партнерами над тем, чтобы через пару месяцев удовлетворить спрос и снизить цены на серию RX 6800. Дефицит видеокарт может сохраниться до второго квартала следующего года.

Тэги: