Большинство исследователей ИИ считают, что технологические компании вкладывают миллиарды в тупиковый путь

Опрос показал скептическое отношение научного сообщества к стратегии масштабирования как пути к созданию сильного искусственного интеллекта

Деньгами проблему не решить — примерно так можно резюмировать позицию большинства исследователей ИИ в недавнем опросе. На вопрос о том, может ли "масштабирование" текущих подходов к ИИ привести к созданию искусственного общего интеллекта (AGI) — универсального ИИ, сравнимого с человеческим мышлением или превосходящего его, подавляющее большинство (76%) респондентов ответили, что это "маловероятно" или "крайне маловероятно".

Опубликованные в новом отчете результаты исследования, в котором участвовали 475 специалистов по ИИ и которое проводилось учеными из Ассоциации по развитию искусственного интеллекта, представляют собой категорическое опровержение давно предпочитаемого технологической индустрией метода достижения прогресса в ИИ — путем оснащения генеративных моделей и дата-центров, используемых для их обучения, большим количеством ресурсов. Учитывая, что все разработчики ИИ декларируют AGI своей конечной целью, можно с уверенностью сказать, что масштабирование широко рассматривается как тупиковый путь.

Огромные инвестиции в масштабирование, не сопровождаемые сопоставимыми усилиями по пониманию происходящих процессов, всегда казались мне неуместными. Я думаю, что примерно год назад всем стало очевидно, что преимущества масштабирования в традиционном понимании достигли своего предела.

— Стюарт Рассел, специалист по компьютерным наукам из Калифорнийского университета в Беркли, участвовавший в организации исследования

В гонке ИИ-вооружений сейчас обращаются чудовищные суммы денег. По данным TechCrunch, инвестиции в генеративный ИИ только в виде венчурного капитала достигли более 56 миллиардов долларов в 2024 году. Большая часть этих средств тратится на строительство или эксплуатацию огромных дата-центров, необходимых для работы генеративных моделей. А Microsoft, например, обязалась потратить 80 миллиардов долларов на ИИ-инфраструктуру в 2025 году.

Соответственно, энергетические потребности также поражают воображение. Microsoft заключила сделку по запуску целой атомной электростанции только для питания своих дата-центров, а ее конкуренты Google и Amazon также подписали соглашения в области ядерной энергетики.

Предположение, что ИИ можно бесконечно улучшать путем масштабирования, всегда было сомнительны. Ярким примером стал недавний экзистенциальный кризис технологического сектора, вызванный китайским стартапом DeepSeek, чья ИИ-модель смогла соперничать с флагманскими многомиллиардными чатботами Запада, якобы при гораздо меньших затратах на обучение и энергию.

Конечно, тревожные сигналы были и раньше. В ноябре прошлого года сообщалось, что исследователи OpenAI обнаружили, что готовящаяся версия их языковой модели GPT демонстрирует значительно меньшее улучшение, а в некоторых случаях вообще никаких улучшений по сравнению с тем, как предыдущие версии превосходили своих предшественников.

В декабре генеральный директор Google Сундар Пичаи официально заявил, что эпоха "легких достижений" в ИИ "закончилась", но отметил, что нет причин, по которым индустрия не могла бы "просто продолжать масштабироваться".

Исследователи изучают более дешевые и эффективные подходы. К примеру, OpenAI использовала метод, известный как "вычисление во время тестирования" (test-time compute) в своих последних моделях, когда ИИ тратит больше времени на "размышления" перед выбором наиболее перспективного решения. Это позволило достичь повышения производительности, для которого в противном случае потребовалось бы огромное масштабирование, утверждают исследователи.

Но этот подход "вряд ли станет идеальным решением", заявил Арвинд Нараянан — эксперт по компьютерным наукам из Принстонского университета.

DeepSeek, тем временем, разработал подход, названный "смесью экспертов" (mixture of experts), который использует несколько нейронных сетей, каждая из которых специализируется в различных областях — "экспертов" — для помощи в поиске решений, вместо того чтобы полагаться на единую "универсальную" модель.

Впрочем, если судить по планам техногигантов продолжать вкладывать миллиарды долларов на дата-центры, компании все еще попытаются "брутфорсом" взять вершину.

- Выбросы парниковых газов Google выросли почти на 50% за пять лет из-за ИИ

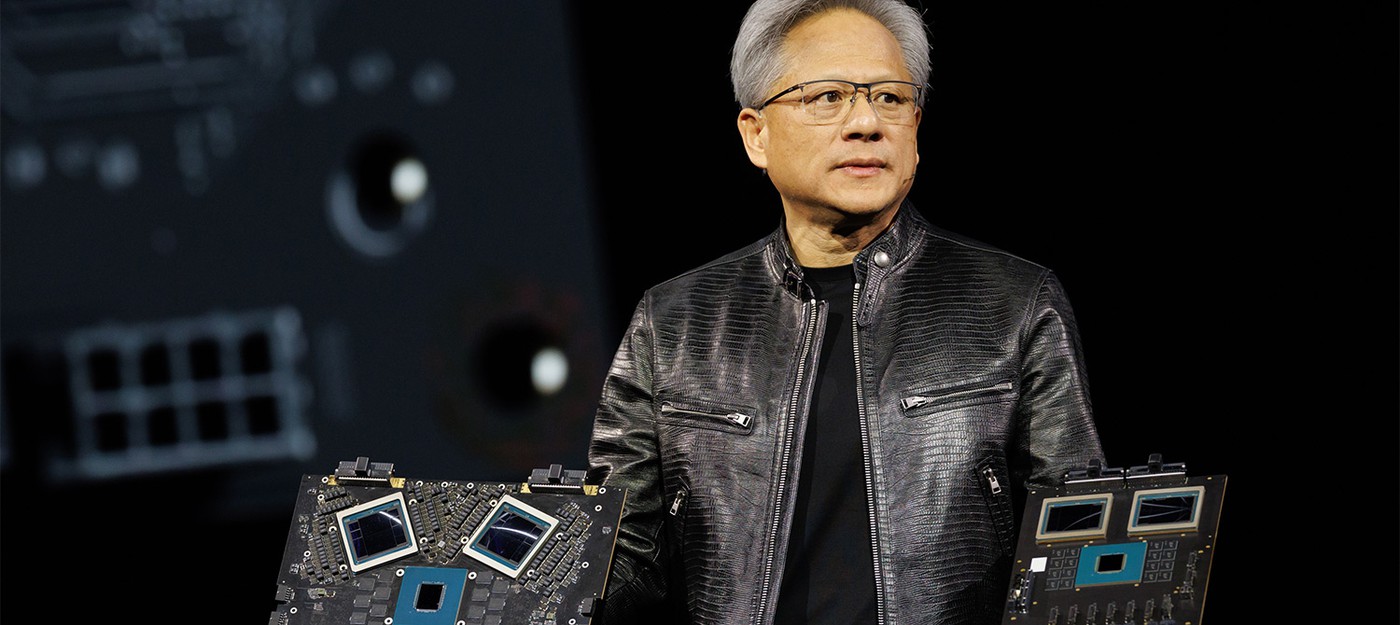

- xAI Илона Маска использует 100 000 GPU Nvidia H100 для обучения модели ИИ Grok 3, а Grok 2 выйдет к августу

- Глава Nvidia представляет будущее, где многозадачные ИИ с суперспособностями превзойдут людей во всей работе

0 комментариев