Слух: Характеристики AMD RX 6000 указывают на высокие частоты GPU

До официального анонса видеокарт AMD RX 6000 еще месяц, но благодаря коду macOS Big Sur уже стали известны характеристики будущих новинок. Данные обнаружил реддитор stblr.

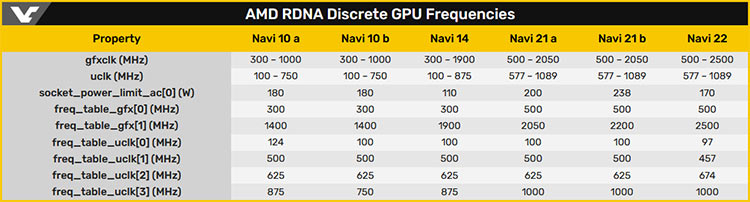

В ходе анализа пользователь наткнулся на спецификации для графических процессоров AMD Navi 21, Navi 22 и Navi 23. Согласно полученным данным, у Navi 21 будет 80 вычислительных блоков CU, у Navi 22 — 40, а у Navi 23 — 32. Что касается шейдерных процессоров, то это 5120, 2560 и 2058 соответственно.

На фоне 10 тысяч ядер CUDA у RTX 3090 количество процессоров даже у Navi 21 не впечатляет. Однако RX 6000 могут оказаться производительными по части частот. У старшей модели 2050-2200 МГц, у Navi 22 — 2500 МГц.

При этом энергопотребление не превышает 240 Вт.

Кроме того, в коде набора AMD ROCm 3.8 было обнаружено и упоминание GPU Navi 31 с теми же 80 блоками CU. Что это за графический процессор и почему его характеристики уже есть, несмотря на то, что Navi 21 ещё даже не был представлен, неясно.

AMD собирается официально представить новую серию игровых графических карт Radeon RX 6000 через месяц — 28 октября. За две недели до этого ожидается анонс новых процессоров Ryzen на базе архитектуры Zen 3.

Ранее директор игрового направления компании Фрэнк Эйзор намекнул, что анонс Radeon RX 6000 не будет "бумажным".