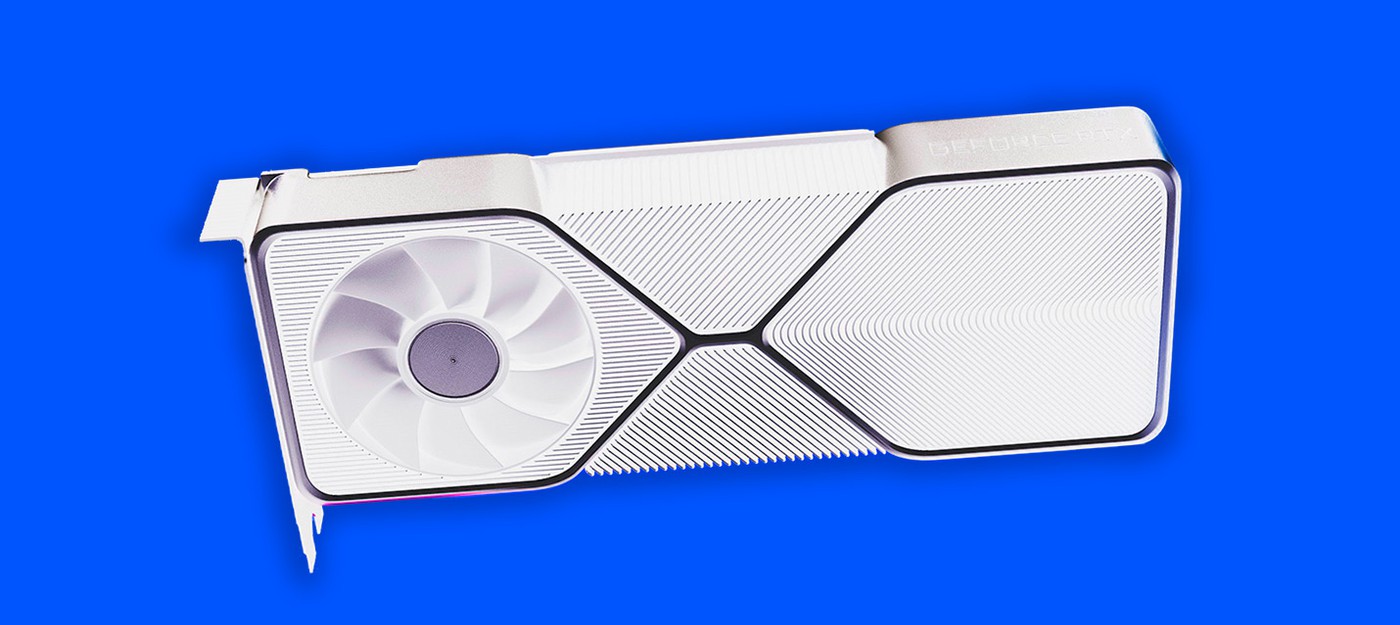

Слух: Nvidia RTX 30 получат новый 12-пиновый разъём питания

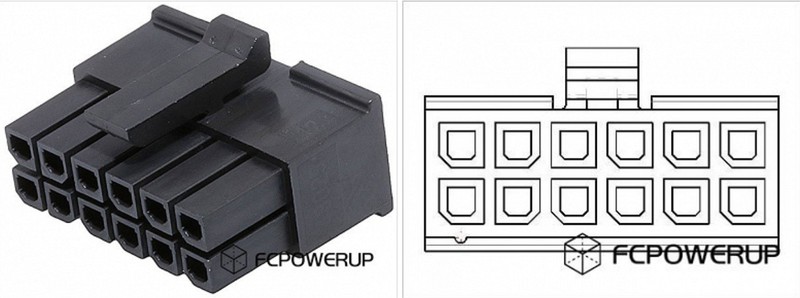

Последнее время слухи о высоком энергопотреблении Nvidia RTX 30 поколения Ampere подтверждаются разными источниками. На сайте fcpowerup появилась информация, что новые видеокарты получат 12-пиновый разъем питания.

Все из-за повышенного энергопотребления, связанного с возросшей производительностью.

Согласно параметрам Molex Micro-Fit, на который и будет похож новый разъем, видеокарта будет обеспечена до 600 Вт мощности. Учитывая что по слухам, RTX 30 будут потреблять не менее 300 Вт, это выглядит логичным решением со стороны Nvidia.

Однако остается вопрос для чего компании потребовался новый разъем, а не применение двух стандартных 8-пиновых. Также неясно, для чего нужен дополнительные 4-пиновый коннектор, о котором указал источник fcpowerup.

Анонс видеокарт состоится в сентябре. Релиз ожидается осенью.

- NVIDIA выпустила ИИ-помощника для владельцев GeForce RTX — он умеет оптимизировать настройки, разгонять видеокарту и другое

- Похоже, Nvidia сокращает производство серии RTX 40 на 50% в преддверии выпуска RTX 50 на архитектуре Blackwell

- Несмотря на рыночную коррекцию, безумная гонка "кто больше потратит" в сфере ИИ продолжается

0 комментариев