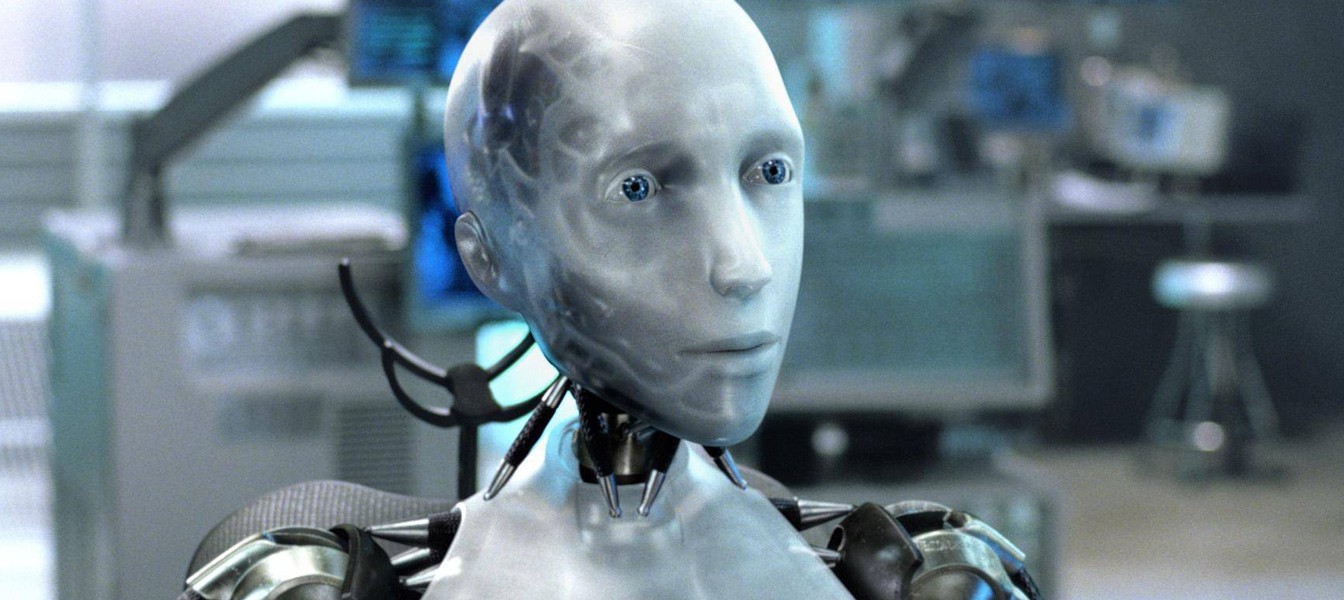

Ученые протестировали первый закон робототехники Азимова

Первый закон робототехники Айзека Азимова гласит, что "Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред." Звучит довольно просто, однако на деле исполнение данного закона потребует от роботов получать массу новой информации и действовать в соответствии с дополнительными законами выбора.

Робототехник Алан Уинфилд из Бристольской лаборатории робототехники в Британии, недавно провел эксперимент по тестированию первого закона Азимова. Он и его команда запрограммировали роботов останавливать других роботов, выступающих в качестве людей, от падения в "яму".

В самом начале робот без проблем справлялся с проблемой. Когда "человек" двигался к дыре, робот отправлялся на перехват и останавливал его от опасности. Однако когда команда добавила второго "человека" и направила его к той же дыре, роботу пришлось выбирать. Иногда у него получалось спасти одного человека, в то же время второй "погибал", редко у него получалось остановить обоих. Однако в 14 из 33 случаев робот тратил так много времени на решение, что оба человека падали в яму.

Ученый описал этого робота как "этического зомби" у которого нет выбора в отношении того, как ему поступать. Хотя он может спасти других соответственно программному своду правил, он не понимает смысла за этими действиями. Уинфилд признает, что когда-то он думал, что роботы не могут принимать этические решения сами по себе, но теперь его ответ изменился: "сейчас – я не знаю ответа."

Данные эксперименты играют большое значение для роботизированного будущего человечества, особенно когда на улицах городов станут появляться умные машины, которым предстоит принимать решение между безопасностью пассажира и людьми в других авто или прохожими. Некоторые сценарии оказывают особенно сложными, попадая в так называемую серую область этики, так что даже люди не всегда могут решить, какое действие этически оправдано.