Команда Ильи Суцкевера из OpenAI разработала инструменты для контроля сверхчеловеческого ИИ

В новой научной работе, опубликованной OpenAI в четверг, говорится, что приход сверхчеловеческого ИИ неизбежен, и компания разрабатывает инструменты, чтобы гарантировать, что он не повернется против людей. Главный ученый OpenAI Илья Суцкевер указан в качестве ведущего автора статьи, но не упомянут в сопровождающем ее блоге, и его роль в компании остается неясной.

Мы полагаем, что сверхразум — ИИ, значительно превосходящий людей по умственным способностям, - может быть создан в течение следующих десяти лет. Решение проблемы того, как выровнять будущие сверхчеловеческие системы ИИ, чтобы они были безопасными, никогда еще не было так важно, и сейчас проще, чем когда-либо, добиться эмпирического прогресса в решении этой проблемы.

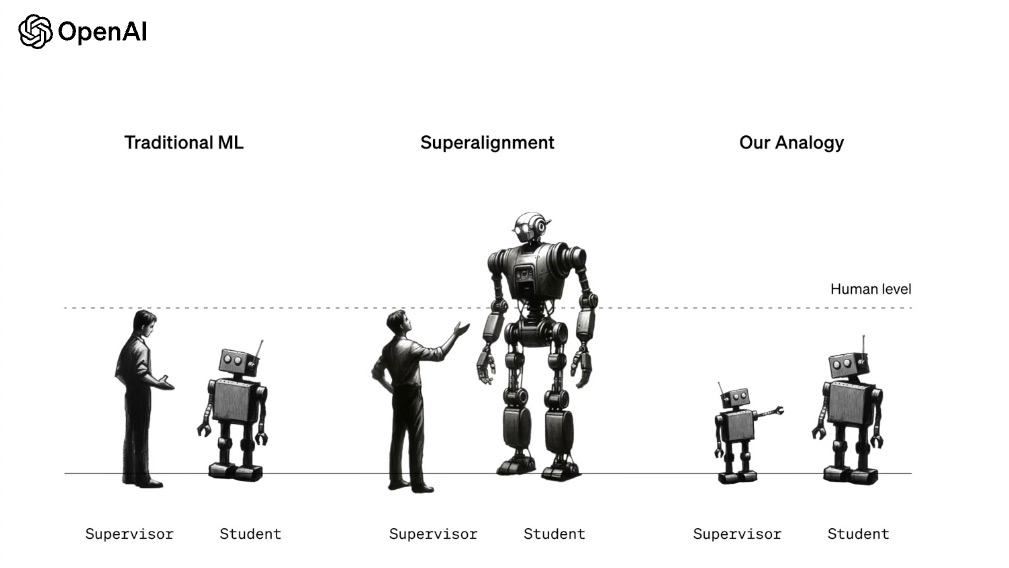

Статья "От слабого к сильному обобщению" — первая работа команды Ильи Суцкевера и Яна Лейке "Супервыравнивание", сформированной в июле для обеспечения того, чтобы системы ИИ, намного превосходящие людей по интеллекту, по-прежнему следовали бы человеческим правилам. Предлагаемое решение? OpenAI должна разработать небольшие модели ИИ для обучения сверхчеловеческих моделей ИИ.

В настоящее время OpenAI использует людей для "выравнивания" ChatGPT, давая ему положительную или отрицательную обратную связь. Так OpenAI гарантирует, что ChatGPT не будет давать людям инструкции о том, как изготовить самодельную напалм в домашних условиях, или приводить к другим опасным последствиям. Однако по мере того, как ChatGPT становится умнее, в OpenAI признают, что людей будет недостаточно для обучения этих моделей, поэтому нам нужно обучить менее сложный ИИ делать это от нашего имени.

Это первый признак активности Ильи Суцкевера в OpenAI с тех пор, как Сэм Альтман объявил, что почти все вернулись в OpenAI, оставив статус Суцкевера неопределенным. Суцкевер, сооснователь OpenAI, был одним из членов совета директоров, стоявших за увольнением Альтмана, и он остается ведущим голосом в сообществе ИИ, выступающим за ответственное развертывание ИИ. Он больше не ведет компанию вперед, но, возможно, у него есть какая-то роль в ней.

Другой руководитель команды "супервыравнивания" OpenAI Лейке в четверг поблагодарил Илью за "разжигание огня", но похвалил других за "продвижение дела вперед каждый день". Комментарии ставят под сомнение роль Суцкевера в завершении этого проекта, несмотря на то, что он его начал.

По сообщениям, последние несколько недель его не было видно в компании, и он нанял адвоката, сообщили источники Business Insider. Ян Лейке и другие члены команды "Супервыравнивание" OpenAI сделали публичные заявления по поводу этой важной работы, но Суцкевер хранит молчание — только ретвитит.

Исследование показало, что обучение больших моделей ИИ меньшими моделями, что называется "слабым-к-сильному обобщению", приводит к более высокому уровню точности в нескольких ситуациях по сравнению с обучением людьми. Большая часть исследования заключалась в использовании GPT-2 для обучения GPT-4. Важно отметить, что OpenAI не убеждена, что это "решение" проблемы супервыравнивания — это лишь многообещающая структура для обучения сверхчеловеческого ИИ.

В целом сверхчеловеческие модели были бы чрезвычайно мощными и, если бы их неправильно использовали или они были бы несовместимы с человеческими ценностями, они могли бы потенциально нанести катастрофический ущерб. Мы считаем, что теперь проще, чем когда-либо, добиться прогресса в решении этой проблемы.

В ноябре ходило много слухов о том, что OpenAI близка к созданию ИИ общего назначения (AGI), хотя большая их часть была слухами. Эта статья подтверждает, что OpenAI активно создает инструменты для управления ИИ общего назначения, но не подтверждает существование AGI.

- OpenAI предупреждает о повышенном риске создания биооружия с помощью будущих моделей ИИ

- OpenAI получила оборонный контракт на $200 миллионов от правительства США

- OpenAI выпустила модель o3-pro с мышление – но что такое "мышление" ИИ и что оно делает?