Вот что гласит исследование, ставшее причиной увольнения Сэма Альтмана из OpenAI

После бурных выходных в Кремниевой долине, где искусственный интеллект оказался в центре корпоративных баталий, бывший глава OpenAI Сэм Альтман триумфально вернулся в компанию. Трения между Альтманом и советом директоров OpenAI вызвали много обсуждений в СМИ и социальных сетях, при этом предполагалось, что разногласия связаны с разделением между коммерческой и некоммерческой природой OpenAI и её холдинговой компании. Однако, согласно новому отчету New York Times, ключевой источник трений был связан с исследованием, опубликованным членом совета — Хелен Тонер.

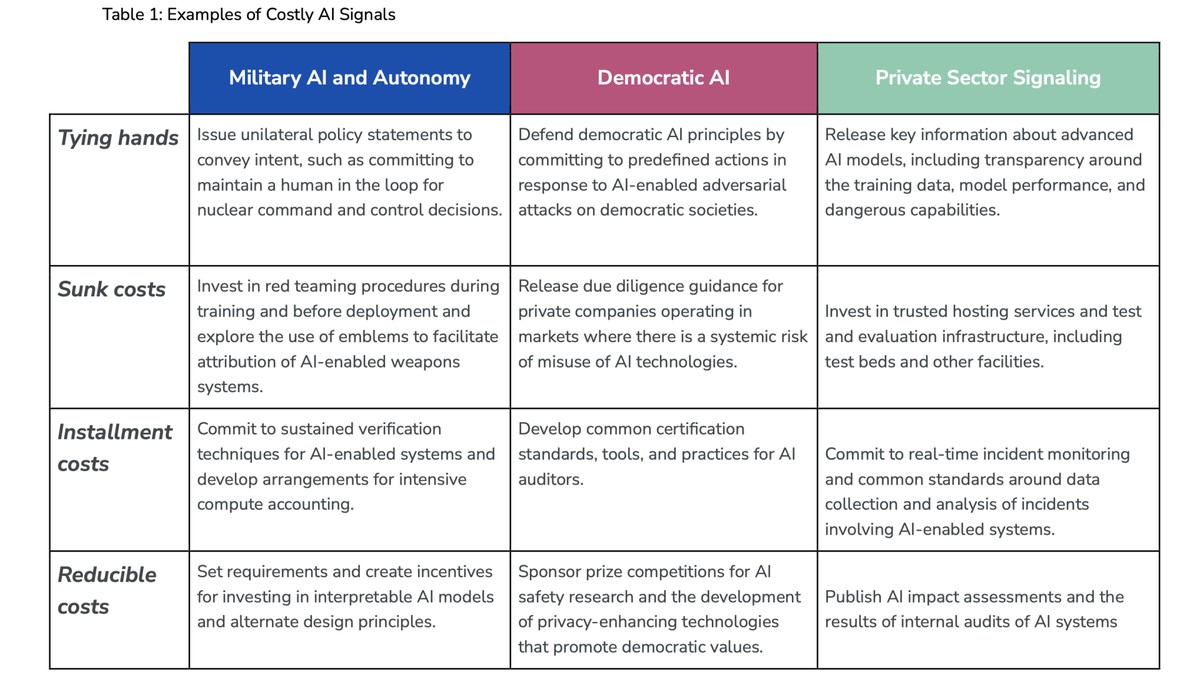

Тонер, директор Центра по безопасности и развивающимся технологиям в Университете Джорджтауна, в октябре написала исследование, в котором рассматривалось, как правительства и компании могут структурировать своё общение, чтобы избежать недопонимания. В докладе, написанном совместно с другими учеными из Джорджтауна, определялись инструменты коммуникации, называемые "сигналами", на которые могут полагаться участники в области национальной безопасности и ИИ для прояснения своих намерений.

В докладе описываются четыре типа сигналов: "связывание рук", "невозвратные затраты", "разовые издержки" и "сокращаемые издержки". Эти подходы варьируются от "связывания рук", ограничивающего фирму политикой или другими анонсами, которые было бы сложно отменить, до "разовых издержек" с более высокими первоначальными затратами (например, дорогостоящими обязательствами), которые уменьшаются со временем по мере накопления выгод.

В частности, доклад Тонер фокусировался на действиях OpenAI вокруг запуска модели GPT-4. OpenAI анонсировала GPT-4 в марте 2023 года, и, согласно авторам доклада, хотя сама модель являлась замечательным технологическим достижением, её значение проявилось только через дополнительные документы.

Эти документы включали карту системы, объясняющую риски, связанные с GPT-4, и то, как OpenAI смягчила их, спеша выпустить первую модель GPT-4 на рынке. Авторы исследования считают её относительно неудачным средством коммуникации для демонстрации приверженности OpenAI к безопасности.

Доклад гласит:

Хотя карта системы в целом хорошо воспринимается исследователями, заинтересованными в понимании рисков, связанных с GPT-4, она, по-видимому, была менее успешной в качестве широкого сигнала приверженности OpenAI к безопасности. Причина этого непреднамеренного исхода заключается в том, что компания предприняла другие действия, которые затмили значение карты системы: в частности, грандиозный выпуск ChatGPT четыре месяца назад.

Если говорить обычным языком, то документ OpenAI о безопасности GPT-4 не смог полноценно показать приверженность компании к безопасности из-за более раннего и громкого запуска ChatGPT.

Исследователи затем сравнили подход OpenAI с подходом её конкурента, Anthropic, и его платформой Claude. Они высоко оценили решение Anthropic задержать запуск Claude, чтобы остановить "ускорение прогресса в области ИИ". Это решение было определено как "дорогостоящий сигнал сдержанности".

Как они выразились:

Задерживая выпуск Claude до тех пор, пока другая компания не выпустит аналогичный продукт, Anthropic продемонстрировала свою готовность избегать именно того типа спешного движения, который, по-видимому, спровоцировал выпуск ChatGPT. Anthropic достигла этой цели, используя разовые издержки, или фиксированные затраты, которые нельзя компенсировать со временем. В рамках данного исследования, Anthropic укрепила доверие к своим обязательствам в области безопасности ИИ, отложив ранний выпуск своей модели и понеся потенциальные будущие потери доходов. Мотивация в данном случае заключалась не в возмещении этих потерь за счет увеличения доли на рынке, а скорее в продвижении отраслевых норм и вкладе в общие ожидания в отношении ответственной разработки и внедрения ИИ.

Отчет NYT указывает, что Альтман был недоволен после публикации доклада, и он поделился своими опасениями с сотрудниками OpenAI по почте. Кроме того, вскоре после этого произошло довольно интересное событие: глава исследовательского отдела OpenAI Илья Суцкевер сначала обсуждал вопрос об увольнении Тонер из совета, но затем удивительным образом решил действовать против Альтмана — решение, о котором он пожалел через несколько дней.