Без паники, но физикам тоже нужны видеокарты

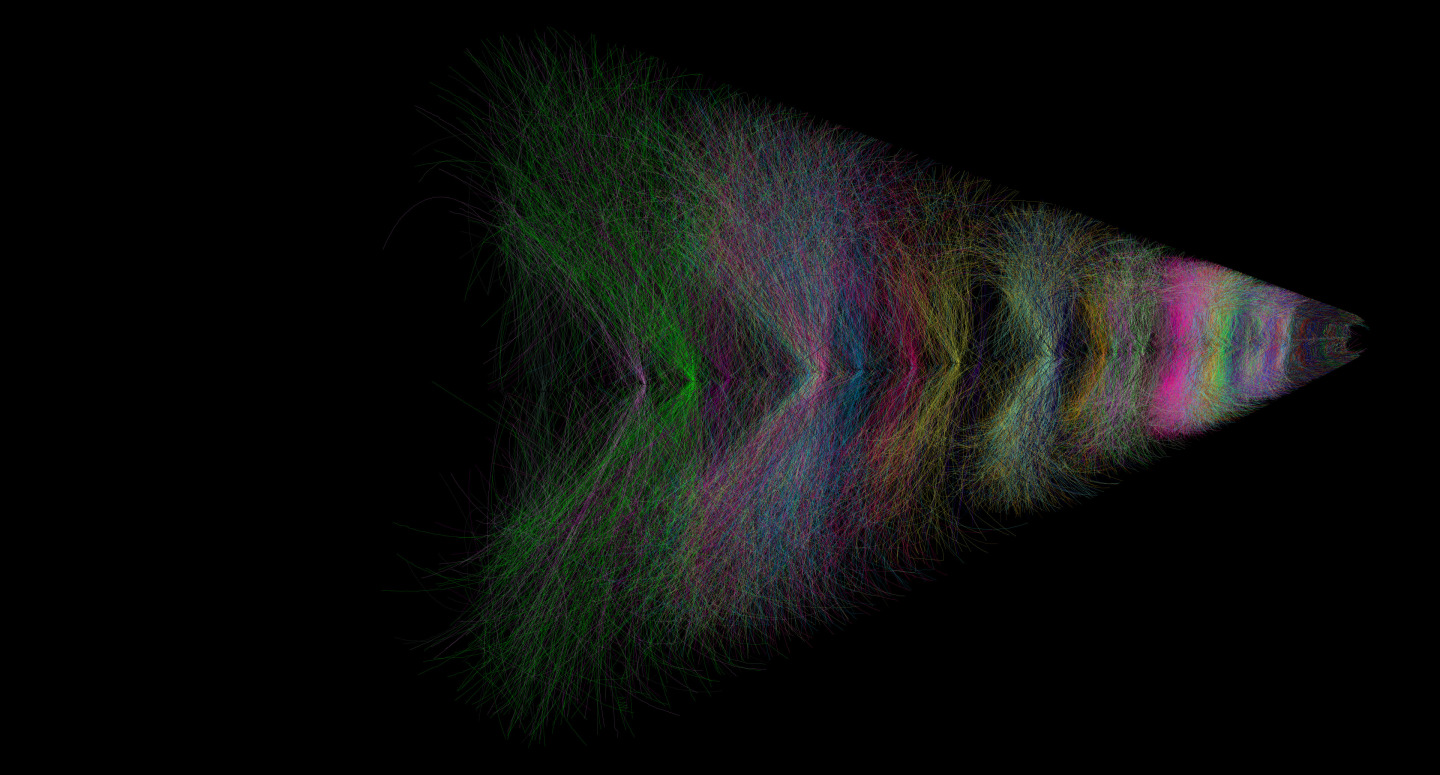

Не спешите хвататься за вилы и факелы, но физики из европейской организации по ядерным исследованиям (CERN) тоже нуждаются в видеокартах, чтобы видеть результаты столкновения частиц. Ученые, которые работают с Большим Адронным Коллайдером (БАК), полагаются на видеокарты Nvidia, чтобы ускорять процесс обработки данных и снижать энергопотребление для этих целей.

Хотя графические процессоры создаются в первую очередь для работы с полигонами, шейдерами и трассировкой лучей, у GPU есть большое преимущество перед традиционными процессорами. Графические карты обладают невероятно высокой вычислительной мощностью при выполнении параллельных задач. И во многих научных сферах такая характеристика гораздо более ценная, чем просто мощность или количество CPU. Тот же БАК использует видеокарты в своих вычислениях с 2010 года, и сейчас ученые мотивируют активнее применять видеокарты в различных экспериментах.

Так как дефицит игровых видеокарт уже создал массу проблем для геймеров в виде спекулянтов и ботоводов, то опасения, что GPU будут уходить еще и ученым, вполне оправданы. Скорее всего ученые действительно станут активнее использовать графические карты в своих вычислениях, но в их случе есть профессиональные решения. Кроме того, если выбирать, кому отправлять видеокарты, то уж лучше ученым — по крайней мере, они будут использовать их для дела, а не майнинга криптовалюты.

Сейчас CERN использует видеокарты прошлых поколений, однако в будущем БАК все же перейдет на пару Nvidia Tesla T4 — профессиональные решения, которые не скажутся на доступности игровых карт.

Анализ CERN показал, что если бы в работе использовались системы из CPU для обработки данных, то им бы потребовалось в восемь раз больше серверов, чтобы проводить реконструкцию и компрессию на уровне, который уже обеспечивают GPU.

Подобные анонсы создают прецедент и информируют научное сообщество в эффективности видеокарт, так что потенциально новость об использовании Nvidia в БАК могут вызвать волну спроса на профессиональные и игровые карты для научных комплексов, в качестве альтернативы CPU. Тем более, что последние могут стоить гораздо дороже GPU и в целом будут потреблять ощутимо больше энергии.

Будем надеяться, что скупать игровые модели сотнями все же не будут.